ProxmoxとPure StorageをFC接続して動作確認しました。

ProxmoxとPure StorageのFC接続の構築手順と構築後の動作確認結果についてまとめました。

本記事ではFC接続の構築手順と構築後の動作確認結果についてご説明します。

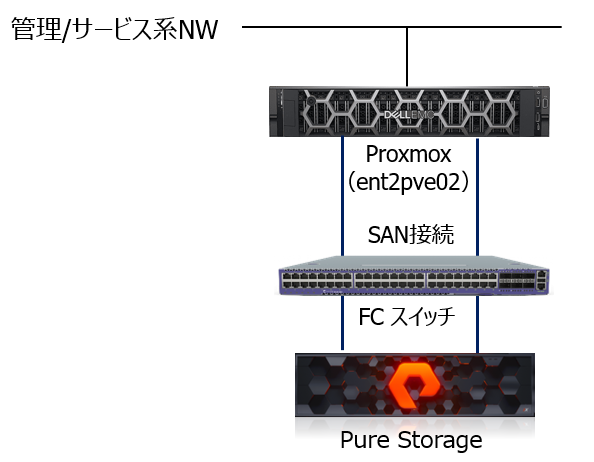

今回の構成図

※カッコ内はホスト名

1台のサーバーにProxmoxを導入し、FCスイッチ経由でPure Storageに接続する構成となります。

前提条件

Pure Storage側でボリュームの作成、及びWWNを含めたProxmoxホスト情報の登録を事前に行います。

Pure Storage設定

| 項目 | 設定 |

| ホスト名 | ProxmoxServer |

| ボリューム名 | ProxmoxVol |

| サイズ | 1TB |

| WWID | 3624a93707b66d01bad8841bc000be396 |

事前準備

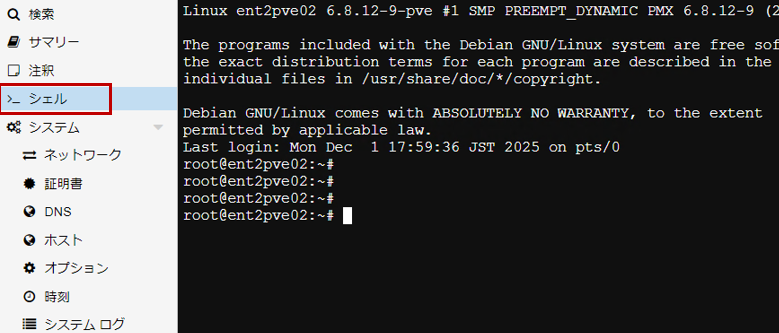

① Proxmox GUIのシェルをクリックします。

② マルチパスI/O管理ツールのインストールをします。

# apt install multipath-tools

![]()

③ サービスが有効であることを確認します。

# systemctl status multipathd.service

設定の流れ

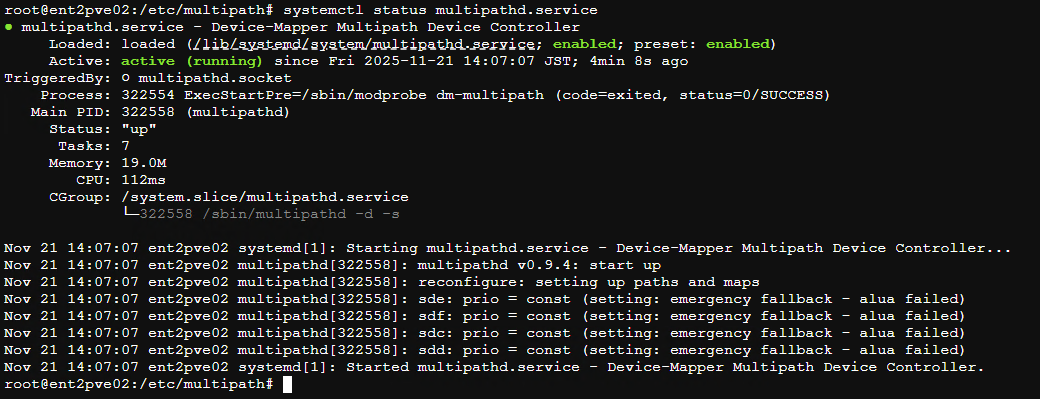

① 次のコマンドを使用して、Pure Storageで作成したVolumeが表示されることを確認します。

# lsblk

※ Pure Storageで作成したボリュームが確認できます(上図、赤枠)。

※ lsblk・・・Linuxシステムでディスクやパーティションなどのブロックデバイスをツリー形式で一覧表示するコマンドです。

※ 4つ(sdd, sde, sdf, sdg)見える理由

マルチパス構成における複数パス認識によるものです。

Pure StorageとProxmoxをFC接続やiSCSI接続した際、ストレージ側の1つのLUN(ボリューム)は、一般的に、冗長構成によりあるホストに対して複数のパスで見えます。Pure StorageのFlashArrayは2コントローラ構成で、各コントローラに複数ポートがあります。検証環境では、2コントローラ×2ポートずつあるため、1つのLUNが4パスで示され、OSは4つのデバイスとして認識します。

・Pure Storageの設計

冗長性と可用性を確保するため、同じボリュームを複数のターゲットポートからホストに示します。

・Proxmoxの認識

マルチパス設定をしていない状態では、OSは各パスを別々のブロックデバイスとして認識します。

そのため、lsblkで見ると /dev/sdd, /dev/sde, /dev/sdf, /dev/sdg のように複数表示されます。

以降の手順で、multipath-toolsを使って複数パスを1つの論理デバイスに統合します。

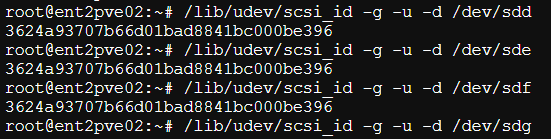

② 次のコマンドを実行して、Pure Storageのボリュームに割り当てられているWWIDを照会します。

# /lib/udev/scsi_id -g -u -d /dev/sdX

※WWID・・・Fibre ChannelやSAS、iSCSIなどで1台1台の機器に割り当てられる固有の識別番号です。

機器をつないでSAN(ストレージエリアネットワーク)などを構築する際に機器を識別する際に使用します。

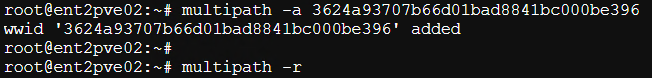

③ 上記コマンド実行で取得したWWID をマルチパスに追加します。

# multipath -a WWID

# multipath -r

※multipath “-r”・・・Linuxのマルチパスコマンドにおいて、マルチパス設定を再読み込みするためのオプションです。新たなパス追加や既存パスが削除された場合や、マルチパス設定を変更した際に当該変更を即座に反映します。

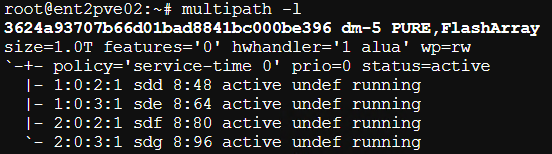

④ WWIDがマルチパスに追加され、アクティブであることを確認します。

# multipath -l

※multipath “-l”・・・Linux のマルチパス構成で 現在認識されているマルチパスデバイスの詳細情報を表示するためのコマンドです。(オプション “-ll”(long listing)は、さらに詳しい情報を表示できます)

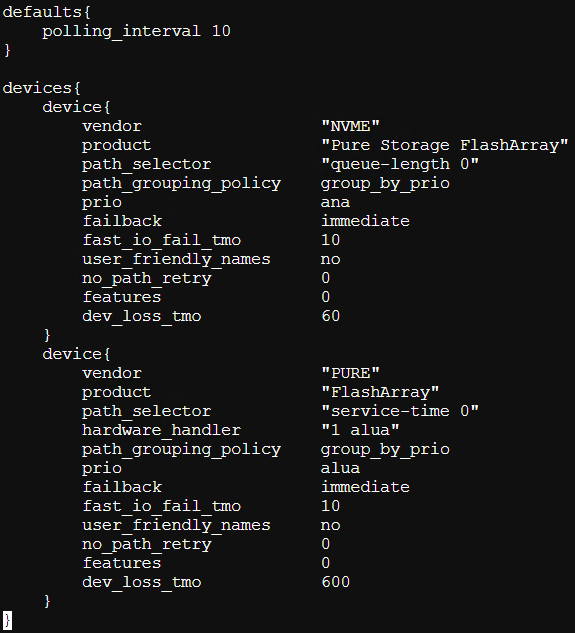

⑤ Pure Storageの推奨に従って/etc/multipath.confを作成します。

(Pure Storage社 推奨されるDMマルチパス設定 参照)

⑥ 以下のコマンドで設定を適用します。

# multipath -r

![]()

ここまでの手順で複数の物理パス(sdd, sde, sdf, sdg)が、マルチパスによって1つのデバイスにまとめられ、その結果 /dev/mapper/<DEVICE_NAME> というファイルが作成されます。

※DEVICE_NAME・・・マルチパスが生成するマルチパスデバイスの名前です。

⑦ 共有ストレージ (LVM) を作成します。

ストレージをProxmoxノードの共有リソースとして使用し、且つ、ストレージ用マルチパス接続するために、LVMデータストアを作成します。以下のLVMコマンドを実行します。

※複数のProxmoxサーバーがある場合は、1台のサーバーのみで実行します。

① # pvcreate /dev/mapper/<DEVICE_NAME>

![]()

※マルチパスで統合されたデバイスをLVMのPV(物理ボリューム)として登録します(ディスクをLVM管理下に置くために初期化)。

② # vgcreate <VG名> /dev/mapper/<DEVICE_NAME>

![]()

※複数のPVをまとめてpure-vgという名前の1つのVG(ボリュームグループ)を作成します(PVをまとめてストレージプールを作成)。

これらの手順が完了すると、共有LVMストレージをProxmox GUIに追加できるようになります。

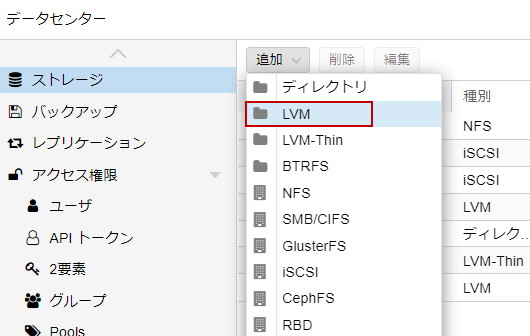

⑧ Proxmox GUIの「データセンター」> 「ストレージ」> 「追加」に進み、「LVM」を選択します。

⑨ 表示される画面でIDを入力し、作成した新しいボリュームグループ(下図、赤枠)を選択します。入力内容を確認し、「追加」を選択します。

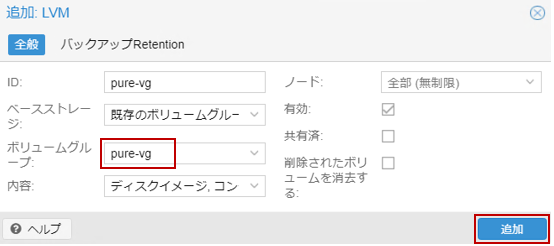

※新たにボリュームグループが登録されます(下図、赤枠)。

動作確認

確認① LVM

複数のVMが作成できることを確認します。

設定手順

Proxmox GUIでVM(Windows Server)を3台新規作成し、各VMは以下の設定をします。

① 各マシン名に「Win01-Pure」、「Win02-Pure」、「Win03-Pure」を入力します。

② システムタブの「TPMストレージ」、「EFIストレージ」で、今回作成したボリュームグループ「pure-vg」をそれぞれ選択します。

上記以外はデフォルト設定とします。

確認結果

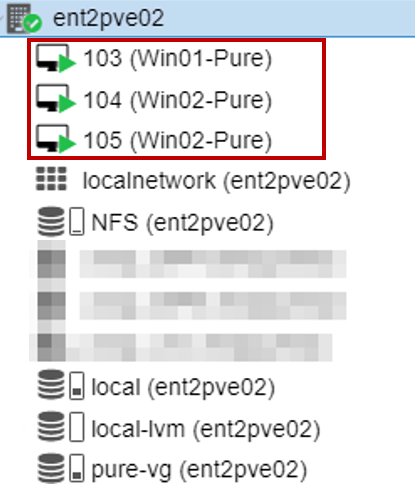

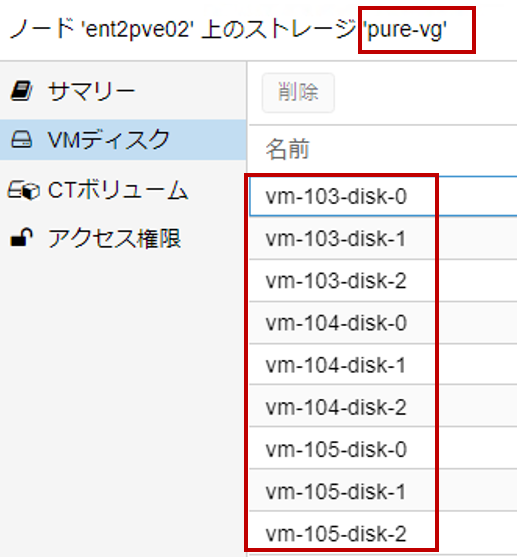

複数のVMを作成することができました(下図、赤枠)。

また、それぞれの仮想マシンのディスクがPure Storageのボリュームに配置されていることを確認しました(下図、赤枠)。

確認② マルチパス(ストレージパスの冗長化)

冗長化したFC結線の片方を抜線しても、仮想マシンの画面表示や動作に影響がないことを確認します。

確認手順

① サーバーに接続している2本のケーブルの片方を抜線します。

② 各VMのOS画面で画面操作を行い、画面表示や動作に問題ないかを確認します。

③ 抜線したケーブルを元通りに結線し、もう片方のケーブルを抜線します。

④ 先程と同様に各VMのOS画面で画面操作を行い、画面表示や動作に問題ないかを確認します。

確認結果

それぞれのケーブルを抜線しても、各仮想マシンの画面表示や動作に影響がないことを確認しました。

まとめ

ProxmoxとPure StorageをFC接続して動作確認しました。

・共有ストレージ (LVM) を作成したことで、複数のVMが作成できることを確認しました。

・マルチパス(ストレージパスの冗長化)の確認として、それぞれのケーブルを抜線しても、仮想マシンの画面表示や動作に影響がないことを確認しました。

終わりに

当社では多数のシステム構築案件の導入実績があり、ProxmoxやPure Storageの構築も承ります。

ご相談は下記フォームよりお問い合わせください。

お問い合わせはこちら