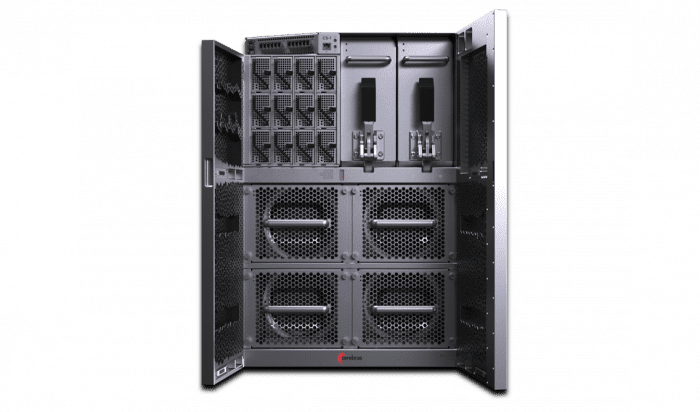

超高速ディープラーニングシステム「CS-2」

Cerebras | CS-2

Cerebras社のCS-2は、モノリシックな巨大半導体チップを実装した19インチラックへ搭載可能な15Uのディープラーニング専用システムで、GPUベースの従来システムと比べて省スペース・低消費電力で超高速な学習処理を行うことが可能です。

ピンチアウトで拡大

「CS-2」には、ディープラーニング専用に設計された21.5cm角の大型半導体「ウェハースケールエンジン(WSE-2)」を搭載しています。「WSE-2」は積和演算を実行する85万個のコアと、効率的なデータアクセスのためにコア毎に高速なローカルメモリを実装し、コア間で非常に高速な通信が可能になるように設計されています。

ピンチアウトで拡大

| CS-1(WSE-1) | CS-2(WSE-2) | |

| 製造プロセス | TSMC 16nm | TSMC 7nm |

| シリコン面積 | 46,225 ㎟ | 46,225 ㎟ |

| トランジスタ数 | 1.2 Trillion | 2.6 Trillion |

| 疎線形代数演算コア | 400,000 | 850,000 |

| オンチップSRAM | 18 GB | 40 GB |

| メモリ帯域 | 9 PB/s | 20 PB/s |

| コア間インターコネクト | 100 Pb/s | 220 Pb/s |

WSEの85万個の疎線形代数演算コアは、多くのニューラルネットワーク向けに最適化されています。

各コアはそれぞれ独立して柔軟にプログラム可能であるため、トレンドに合わせてどんなアルゴリズムでも実行することができます。

WSE上の全てのコアは、Swarmと呼ばれる220Pb/sの2次元メッシュ構造の通信ファブリックでシリコン上で相互に接続されています。

Swarmによるシリコン上での通信は、GPU同士間の通信と比べて非常に小さなレイテンシと消費電力で高速通信することが可能です。

WSEはオンチップSRAMを大量実装しており、モノリシックなシリコンチップ上でPB/sクラスのトータルメモリバンド幅でアクセス可能です。

これは、業界を代表する他社GPU製品と比べて1,000倍以上のメモリ量、12,800倍以上のメモリバンド幅があることを意味します。

シリコンチップ上の各コアにローカルSRAMを分散配置することで、より低レイテンシで低消費電力を実現しながら高速で柔軟な演算処理が可能になります。

CerebrasのソフトウェアプラットフォームではTensorFlowのような主要なMLフレームワークを統合しており、ユーザーは使い慣れたツールを使いモデルを簡単にWSEに投入することが可能です。

また、一般的なディープラーニング計算用のスタンダードな拡張ライブラリとカスタムカーネルを開発するためのSDK(Cインターフェイス)の両方を提供しており、それを使って研究者がマシンラーニングイノベーションの限界を突破できるよう支援します。

ピンチアウトで拡大

Cerebrasグラフコンパイラ(CGC)は、WSE上で実行できるようにニューラルネットワークを自動的に変換します。

CGCはあらゆる段階でWSEの使用効率を最大化するよう設計されており、演算リソースを最大限使うためにどの処理をどのくらいのリソースに割り当てるかを計算してから、最小の通信レイテンシで処理できるよう各処理の割り当て場所とルーティングを自動的に決定します。

ピンチアウトで拡大

CerebrasソフトウェアプラットフォームにはSDKを使ったカスタムカーネルの開発だけでなく、一般的なディープラーニング計算用のスタンダードな拡張ライブラリも含まれています。デバッグやプロファイリング用の総合パッケージツールによって、ユーザー自身が処理を最適化することが可能です。

ピンチアウトで拡大

|

疎線形代数演算コア |

850,000 |

| オンチップメモリ | 40 GB SRAM |

| メモリ帯域 | 20 PB/s |

| コア間帯域 | 220 Pb/s |

| システム I/O | 1200 Gb/s: 12 x 100 Gig Ethernet |

| プロセス | TSMC 7nm |

| サイズ | 15 Rack Units (26.25 inches) |

ピンチアウトで拡大