GPUアーキテクチャの進化とLLM活用:NVIDIA Transformer Engineが拓く未来

近年、ChatGPTをはじめとする大規模言語モデル(LLM)の活用が急速に進み、企業においても自社開発やカスタマイズへの関心が高まっています。自社LLMを持つことは、データセキュリティの確保や独自領域への最適化、競争力強化といった大きなメリットがありますが、その実現には膨大な計算資源が必要不可欠です。

これらの計算資源の中核を担うのがGPUですが、GPUはここ十数年の間に大きな進化を遂げました。そして現在、その進化をさらに前進させ、LLMの開発をより効率的かつ現実的なものにしているのが「NVIDIA Transformer Engine」です。本記事では、GPUアーキテクチャの進化から自社LLMカスタマイズの可能性を示し、Transformer Engineがもたらす新しい可能性について解説していきます。

LLMカスタマイズのメリットとオープンソースLLMの広がり

ChatGPTやGemini、Copilotなど、クラウドサービス上で利用可能なプロプライエタリモデルは低価格かつ簡単にAIを活用できるため、すでに多くの人が利用していると思います。しかし、これらのクラウド上で利用可能なLLMはセキュリティなどの観点から自社データの活用が難しく、限定的な利用に留まっている方も多いのではないでしょうか。

このような問題を解決すべく、多くの企業や研究者が注目しているのが「自社専用にカスタマイズしたLLM」の開発です。LLMを自社の独自データによって学習、チューニングすることで、以下のようなメリットが得られます。

- 独自データの活用

自社の過去データや専門知識をモデルに学習させることで、一般的なLLMでは応えきれない業務課題に対応可能になります。 - サービス差別化

特定の業界や業務に最適化された応答を実現できるため、競合との差別化につながります。 - セキュリティ・プライバシーの強化

外部クラウドに依存せず社内でモデルを運用することで、機密情報の漏洩リスクを低減できます。

こうした自社カスタマイズの動きに追い風を送っているのが、近年増えてきたオープンソースLLMです。近年ではGitHubやHugging Faceを中心に様々なオープンソースモデルが公開され、誰でも利用・カスタマイズできる環境が整いつつあります。例えば、代表的なオープンソースLLMには以下のようなものがあります。

-

LLaMA(Meta)

-

MPT(MosaicML)

-

Falcon(Technology Innovation Institute)

-

Tsuzumi(NTT)

これらオープンソースLLMは、様々なパラメータ数やトークン数のものが準備されており、企業は自社の用途や計算リソースに合わせてモデルを選択し、効率的にカスタマイズすることが可能です。GPU等の計算リソース不足から独自LLMの開発をあきらめている方も、軽量なモデルからその効果を試すことができるようになっています。

GPUアーキテクチャの進化:Transformer Engine

現在、前述した自社カスタマイズLLMの開発や運用を現実的にしているのがGPUの存在です。大量のパラメータを持つモデルを学習・推論するためには膨大な計算量が必要であり、GPUの性能と効率がLLMカスタマイズの可能性を大きく左右します。そのため、LLM活用の拡がりとともにNVIDIAが提供するGPUも大きな進化を遂げています。Tensorコアによる演算性能の向上やGPUメモリの増加などももちろんですが、近年さらに大規模化するLLMに対応するために登場したのがNVIDIA Transformer Engine です。Hopper世代のGPU(H100)から搭載されたこの新機能は、従来のFP16よりも少ないビット幅である FP8 を活用し、演算効率とメモリ効率を飛躍的に高めます。ここでは、このNVIDIA Transformer EngineとFP8について簡単に説明しようと思います。

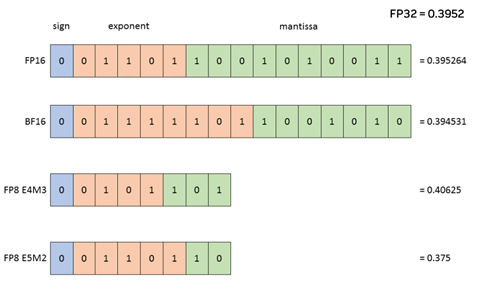

まず、FP8について紹介します。FP8とは、図のように8bit で浮動小数点数を表現するデータフォーマットです。

このFP8を利用するメリットには以下の点があげられます。

- 計算速度の向上

FP8Tensorコアの処理性能はFP16の2倍 - GPUメモリの節約

データフォーマットが半分になるので、計算するTensorサイズも半分 - 量子化による精度低下を防ぐ

推論時と同じデータ精度を用いるため、量子化時にモデル精度が低下しにくい

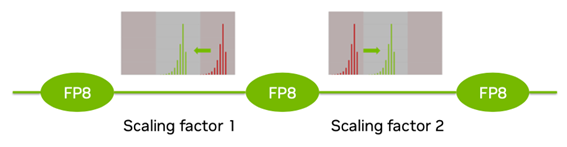

以上の点から、FP8はLLM開発において非常に有用なデータフォーマットです。しかし、先の図からもわかる通り、FP8はダイナミックレンジがかなり狭いデータ形式となるため、広い範囲の値を表現することが困難です。そこで、NVIDIA GPUのFP8トレーニングでは、Tensor毎に個別のScaling Factor を持ち、以下の図のように値をFP8で表現可能な範囲へスケールしてFP8を使用します。

このような工夫によって、FP8のメリットを生かしつつ、ダイナミックレンジが狭いという弱点を克服しています。このとき、スケーリングによって計算が増えていると思われるかもしれませんが、この計算がGPU処理においてボトルネックにならないよう自動で効率的に処理を行ってくれるのがTransformer Engineになります。つまり、Transformer Engineを使用することで、ユーザーはFP8の弱点を気にすることなく、FP8のメリットを生かしたLLM開発が可能になるのです。

最後に

本記事では、オープンソースLLMとNVIDIA GPUの進化について紹介し、LLMの自社カスタマイズの可能性について示唆しました。LLMの自社カスタマイズは、独自データの活用やセキュリティ強化、サービス差別化といった大きな価値を生み出します。

今回紹介したオープンソースLLMやNVIDIA GPUは今も進化を続けています。オープンソースLLMでは、先日、OpenAIから低コストかつ高精度なgpt-ossが発表されました。GPUについても、最新のアーキテクチャ Blackwellが搭載されたGPU製品が次々にリリースされており、FP4などのより大規模なLLMを効率的に扱うための新機能や改良がさらに増えています。

これらの進化により、LLMの学習や推論はさらに高速化され、電力効率やスケーラビリティの面でも大きな進展が期待されます。企業におけるAI活用の波に乗り遅れないよう、LLMの自社カスタマイズをあきらめていた方も、本稿を読んであらためて検討いただけると幸いです。

本記事でご紹介した内容に関心を持たれた方や、自社でのLLM活用・GPU導入についてご相談を検討されている方は、ぜひお気軽に当社までお問合せ下さい。専門の担当者が、技術面や導入の可能性についてご案内いたします。